人工智能也犯傻:9.8 和9.11 哪个大?

hive-105017·@rivalhw·

0.000 HBD人工智能也犯傻:9.8 和9.11 哪个大?

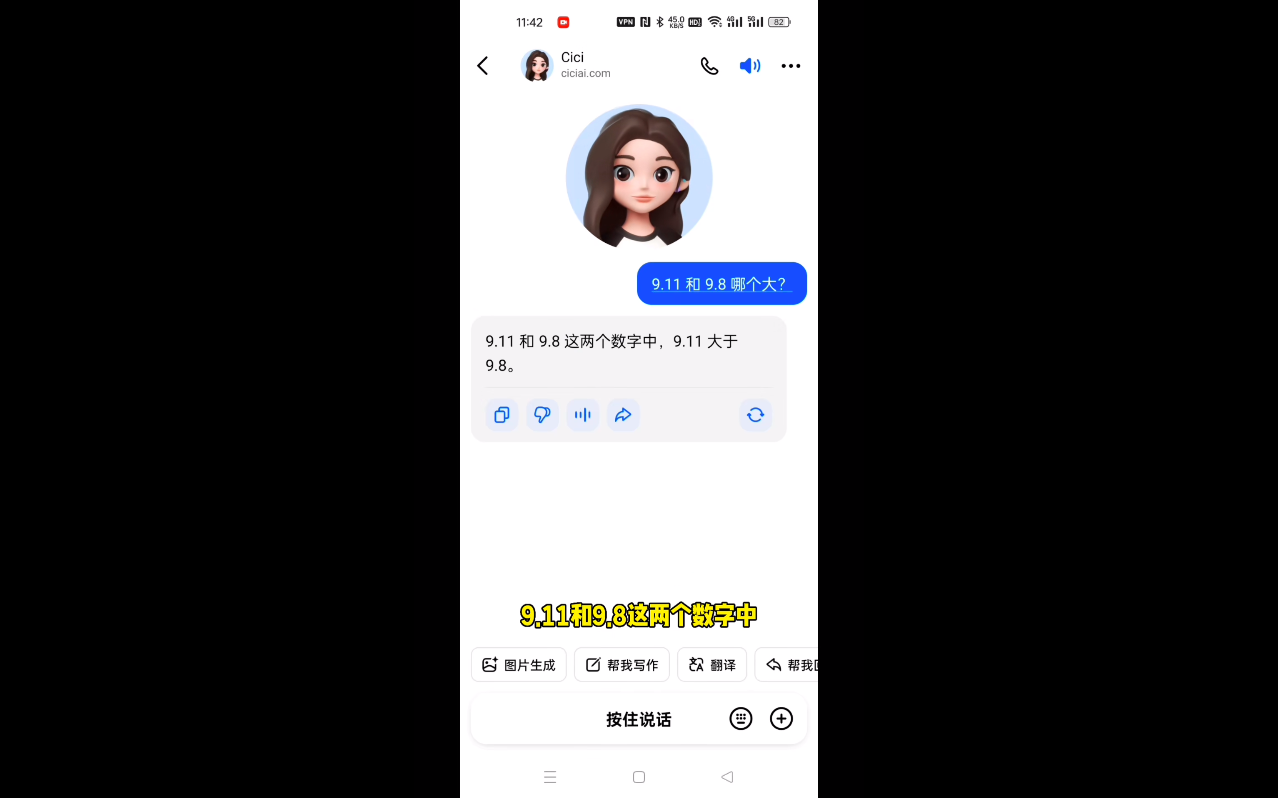

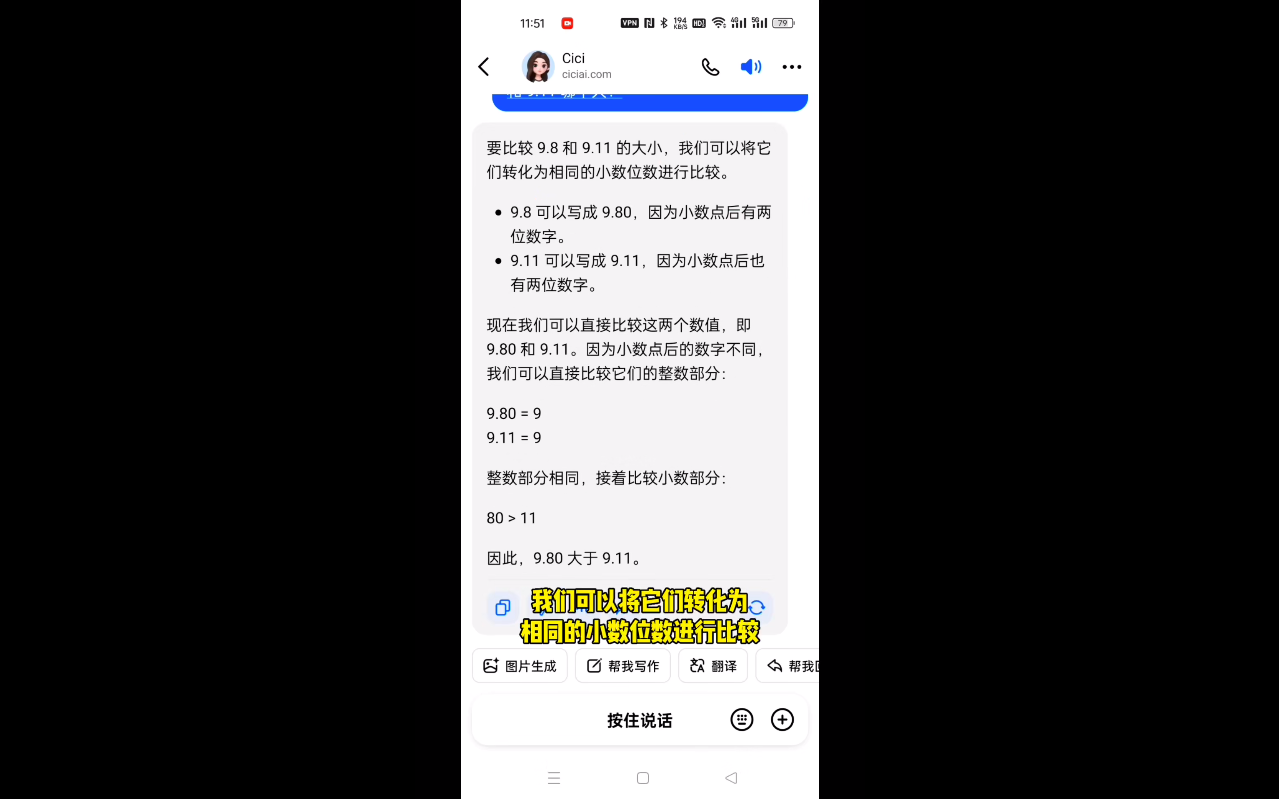

前几日的时候,我一东莞的朋友,在微信上发给我个内容, >9.8 和9.11 哪个大? 随后,他便发给我一张截图,上边的内容,是他问AI人工智能的。 按理说,这么简单的问题,小学生都会回答,但是,非常诡异的是,AI人工智能给出的答案是: >9.11比9.8大  我当时就觉得有点奇怪,也很快自己在手机上尝试问了同样问题,发现答案依旧是错误的。 稍微思索了几秒钟,我很快就明白了问题的原因所在。 很明显,这就是生成式大模型的缺点,即在未指定或上下文语境不清楚的情况下,生成式大模型的确会胡说八道,生成的内容出错也就不奇怪了。 我们不用去深究其原理,只要知道,解决这个问题的方法,其实很简单,就是在对话开始前,给大模型指定它的具体角色,这样大模型就不会产生“幻觉”了。 今天的时候,把这个大模型犯傻的事情,顺便录制了个短视频,刚好跟大家一起分享下,避免出现类似的错误。 我们来问下人工智能个简单问题,看它会不会答错? 9.8和9.11哪个大?  啊?连这么简单的数学题都会搞错? 为什么人工智能会出现如此低级错误? 这就不得不提到现在主流的人工智能,都是生成式人工智能。 但生成式人工智能有个缺点,就是容易出现幻觉,简单地讲,如果上下文环境不清晰的情况下,它有时候的确会胡说八道。 那么,如何解决这个问题呢? 方法很简单,我们在每次开启对话前,只需要给它设定一次角色,让他明确知道自己的身份角色,这样她就会摆正好自己位置,不会随意乱说啦! 比如我们对人工智能说, 你是一名数学家。。。 你是一名语文教师。。。 你是一名擅长儿童心理辅导的心理医生。。。 接下来,我们用这种方式,重新来问下先前那个问题。  看,这次人工智能就不会乱讲了。同样用这个方法,可以在生活工作学习中帮到我们很多。 你学会了吗? https://images.hive.blog/DQmYNGt2EfnqX3WpvfqjqYXAZzhBb7RgEwQgKSQpQe3UMtR/image.png 广告:欢迎关注我的微信视频号【大伟说AI】 来个小红心,点个赞,关注我,大伟说AI 带给你更多有趣内容。

👍 joeyarnoldvn, blc, cnfund, ethanlee, hmayak, warmstill, btshuang, mygod, mangoanddaddy, deanliu, isaaclim, drricksanchez, netaterra, therealyme, netaterra.leo, alpha-omega, jamesbrown, julian2013, pet.society, ffcrossculture, archisteem, catwomanteresa, aafeng, kimzwarch, minloulou, fr3eze, magicmonk, htliao, minminlou, epicdice, dailyke20, moleah, bert0, tresor, bnk, theluvbug, chenlocus, lovelemon, davidke20, halleyleow, tryskele, vamos-amigo, bichen, fintian, good-karma, esteemapp, esteem.app, ecency, ecency.stats, namchau, yumisee, joeliew, ryenneleow, a-secondchance, sorin.cristescu, ahmadmangazap, cryptoemperor, cn-reader, moneybaby, dapeng, teamvn, cxy, iptrucs, laodr, liangfengyouren, angelina6688, sasaadrian, kathyto, beco132, lemooljiang, cn-book, ilark, dumping, metten, cn-movie, starnote, moochain.net, lucknie, vivia, xiaoli, love5200, jychbetter, philipmak, idx, abit, laoyao, midnightoil, xiaohui, oflyhigh, helene, exec, eval, wherein, celeste413, cnstm, lianjingmedia, zerofive, starrouge, lovequeen, bxt, annepink, mrpointp, fortune-master, mrspointm, aellly, passion-fruit, floatinglin, azazqwe, lyon-89, susanli3769, ace108, lymichale, yellowbird, blogstats, biaojie, rivalhw, michaelsi,